Всем привет! Недавно я столкнулся с такой проблемой, что страницы моего блога индексировались по разным адресам и разделам.

Всем привет! Недавно я столкнулся с такой проблемой, что страницы моего блога индексировались по разным адресам и разделам.

Всё дело в том, что я использую ЧПУ (Человеко Понятый Урл). ЧПУ позволяет сделать страницы в формате .html, что очень удобно для посетителей и поисковиков!

Я решил, что нужно рассказать как сделать robots.txt для Яндекса имаксимально совместимый с ЧПУ на WordPress!

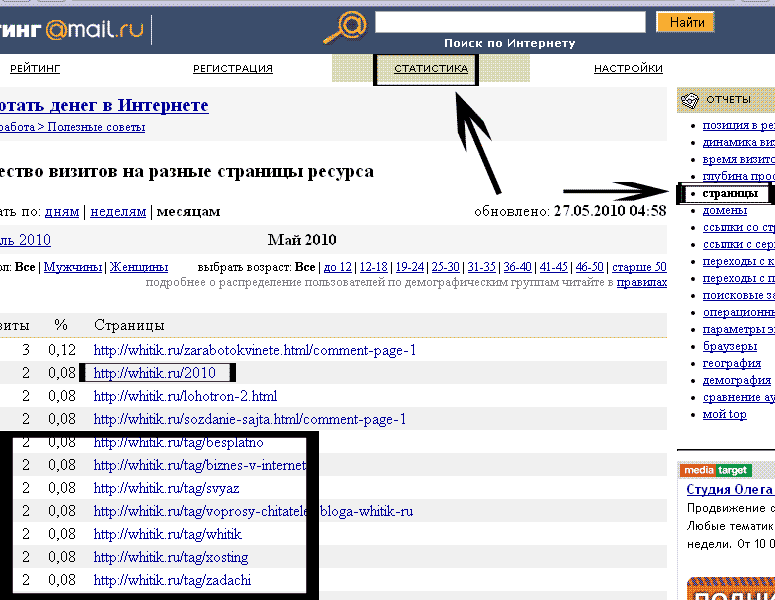

Я зашел в статистику майл.ру, раздел Страницы и посмотрел, какие страницы моего сайта в поиске и ужаснулся…

Эти разделы я не хочу видеть в поисковой выдаче, потому, что они дублируются со страницами ЧПУ. После анализа страниц и разделов, я сделал robots.txt который хорошо подходит для Яндекса и движка WordPress с использованием ЧПУ:

User-agent: * Disallow: /redirect Disallow: /tag/ Disallow: /wp-login.php Disallow: /wp-register.php Disallow: /wp-admin/ Disallow: /wp-includes/ Disallow: /wp-content/themes Disallow: /wp-content/plugins Disallow: /wp-content/languages Disallow: /wp-content/cache Disallow: /trackback Disallow: */trackback Disallow: */feed Disallow: /*feed Disallow: /feed Disallow: /?feed= Disallow: /?s= Disallow: */comments Disallow: /*comment-page-* Disallow: /?p Disallow: /*.js$ Disallow: /*.inc$ Disallow: /*.css$ Disallow: /search Disallow: /xmlrpc.php Host: whitik.ru Sitemap: http://whitik.ru/sitemap.xml

Вот так выглядит мой файл robots.txt для Яндекса. По прошествии некоторого времени из Яндекса «отвалились» не нужные страницы, можете сами проверить: http://yandex.ru/yandsearch?site=whitik.ru&text=&ras=1&lr=194

Можно конечно поспорить, стоит ли исключать ненужные страницы из поиска или нет? Многие говорят, что дублированный контент ничего хорошего не дает и что поисковики за это могу пессимизировать!

Как сделать robot.txt для яндекса

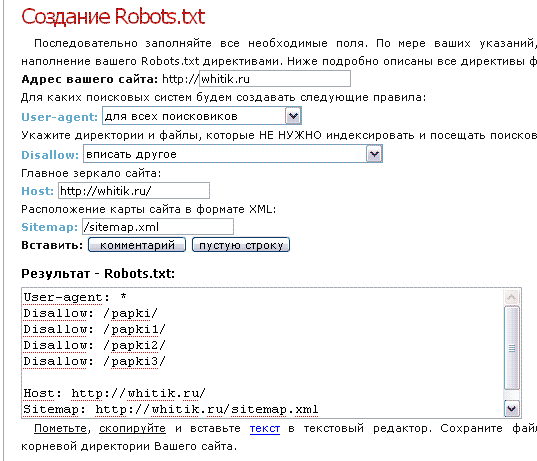

Если же у Вас возникли сложности при составлении роботса, могу посоветовать хороший сервис, по генерации robots: http://htmlweb.ru/analiz/robots.php

В данном сервисе всё просто! Вам нужно всего лишь узнать какие файлы и папки Вы хотите исключить из поиска и добавить их в «Disallows /».

Помните, что для закрытия папки от индекса нужно писать: Disallow: /papka — (Все файлы в папке не будут индексироваться).

А для закрытия от индекса файла типа file.php, нужно писать: Disallow: /file.php

Если Вам нужно закрыть от индекса всего один файл в папке, то это можно сделать так: Disallow: /papka/file.php

Ещё раз

Disallow: /wp-admin/ — запрещает индексировать файлы из директории wp-admin, но не запретит индексировать файлы из директорий, вложенных в wp-admin!

Disallow: /wp-admin — запрещает индексировать всё, что находится в папке и в подпапках!

Надеюсь данные советы помогут Вам в работе!

Большое спасибо за эту статью. Для меня она оказалась очень полезной!

Актуальная статейка, спасибо

Попробую воспользоваться ресурсом для создания файла robot.txt. А возможно ли его создать для сайта на narod?

Спасибо! :)

Интересовало именно / — закрытие и открытие целой линии страниц)))

Нифига так и не полял :( Как сделать robot.txt для яндекса, чтобы он отлично работал и все страницы сайта индексировались как надо?

Понятно все с роботсом. Надо авто для создание этого файла добавить.